kafka抽取

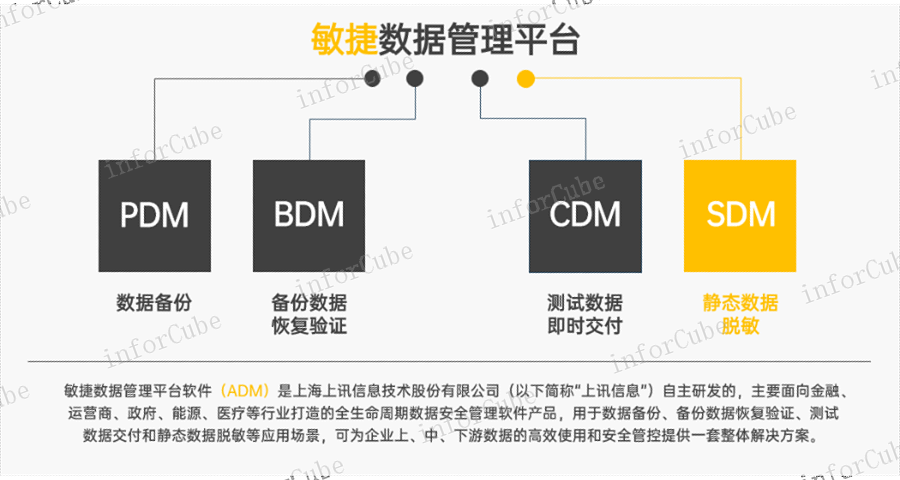

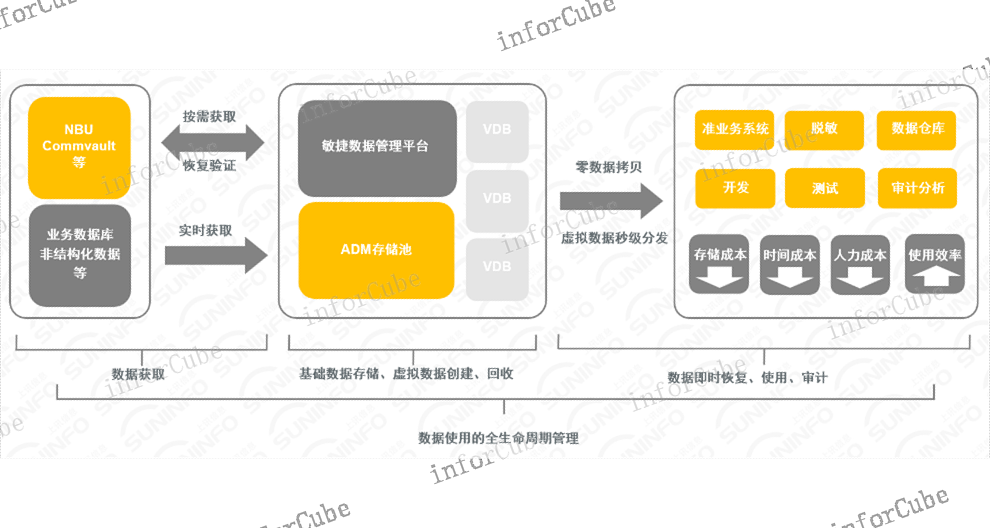

上讯信息敏捷数据管理平台(Agile Data Management)简称ADM,是采用基于CDM(副本数据管理)的数据库虚拟化技术,为企业上中下游数据的备份恢复、数据验证、安全***、分发交付提供的面向数据全生命周期的安全管理解决方案,在保证数据安全使用的同时,提高了数据使用效率并降低了数据存储成本。ADM由数据备份管理、备份校验管理、数据副本管理、数据脱敏管理组成,实现了数据复制容灾、数据存储管理和数据流程管理,通过自动化流程任务编排的方式实现了数据使用的成本控制、版本管理与开发利用,充分发挥了数据资产的潜在价值。上讯敏捷数据管理平台ADM产品高效压缩存储池,节省大量存储资源。kafka抽取

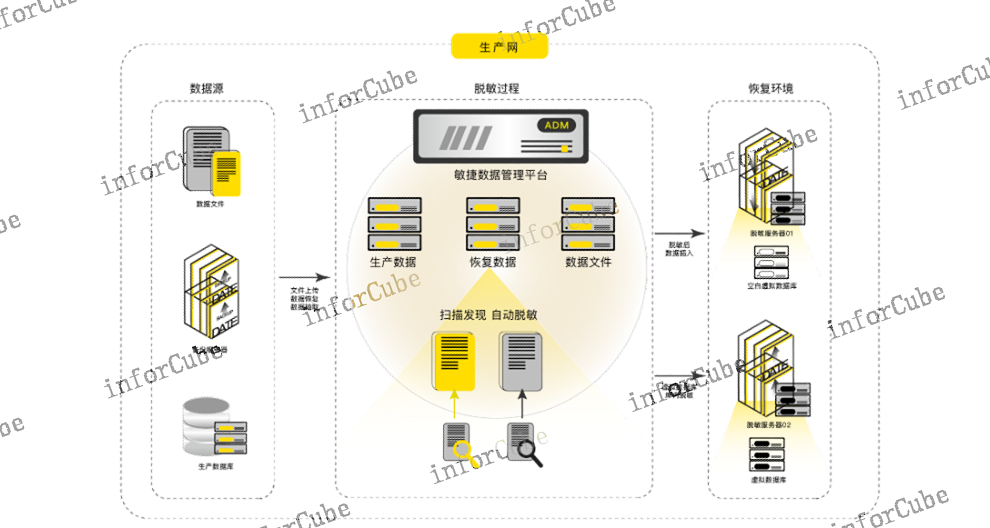

通过敏捷数据管理平台ADM产品的部署实施,采用数据库虚拟化技术,快速将数据交付到开发、测试网,有效减少开发、测试场景中测试数据的准备时间,提高了开发、测试环境搭建的效率。ADM内置独有的高效压缩存储池,平均压缩比3:1,存储即压缩,降低了基础数据源获取的存储成本,只需一份基础数据源,即可快速拉起多份虚拟数据库,节约了存储成本10倍以上。ADM通过虚拟数据库快照功能,可以灵活地对虚拟数据库的状态进行管理和维护。使用人员可以随时保存当前的数据库使用状态,用于开发、测试的数据版本迭代。变形规则截断上讯ADM产品的数据备份模块实现了数据库、文件、虚拟化平台的备份恢复。

上讯敏捷数据管理平台(ADM)支持重复数据删除技术,在典型的重复数据删除技术中,根据不同的数据备份场景选择适合的重删策略与粒度方案。在确定重删策略与粒度后,会根据输入侧不同粒度(卷级、文件级、块级)的数据采取不同的数据切分策略,并依据任务级与全局指纹库提供自适应源端的全局重删算法与策略,当前支持源端块级、文件级重删和并行重删技术。源端重删是采用基于内容的可变长数据切分算法,通过对数据块进行哈希算法的标记,即指纹(Fingerprint),在指纹库中寻找相同的指纹。如果存在相同指纹,则表示已保存了相同的数据块,ADM则不再保存此数据块,而是引用已存在的数据块,从而节省更多的备份空间。该算法还可以智能识别已修改的数据和未修改的数据,从而避免因修改数据位移而导致的未修改数据切分到新数据块中的问题,较大限度地提升重删性能和重删率,为避免数据备份过程中冗余网络传输与存储开销,在源端设置粗粒度前置数据校验可以明显缩小备份传输过程中的数据冗余,目的在于不备份任意一个冗余数据。

ADM产品生产数据备份恢复与异地容灾对生产数据包括数据库、文件、虚拟化平台、容器、云服务器等进行备份,对带库进行数据归档,支持长久增量备份、数据压缩存储、加密传输、重复数据删除等技术,采用挂载恢复方式,恢复时间为分钟级、恢复粒度为秒级。支持数据远程复制实现异地容灾,对备份数据进行双重保护。

ADM产品备份数据自动化恢复与有效性验证ADM可以对接备份系统如NetBackup、CommVault、NetWorker等,检索备份策略自动恢复备份数据和备份文件,完成验证输出结果。全自动化恢复验证,可以满足用户对当前备份数据的可恢复性验证、恢复后的完整性验证,覆盖备份数据和备份文件的恢复,支持虚拟挂载恢复和物理恢复双重方式。 副本数据管理CDM产品能针对开发测试场景快速提供测试数据。

敏捷数据管理平台ADM的关键技术如下:l***数据获取方式数据获取的目的是将不同的数据源实时或者按需同步到平台内,根据不同类型的数据源,数据获取方式分为三种,保证覆盖全部数据源获取方式:①支持实时同步应用数据库;②支持按需同步关系型数据库;③支持与备份系统对接恢复数据。l核心专利技术—数据库虚拟化技术ADM内置一套数据库虚拟化管理程序,虚拟数据库是通过一份基础数据源创建的数据副本,一份基础数据源可以生成多个虚拟数据库,虚拟数据库可读可写,虚拟数据库状态可实时保存。虚拟数据库创建时间为分钟级,且不占用额外的存储空间。上讯ADM能提供面向企业数据使用的成本控制、版本管理与合理合法开发利用。建表

信息敏捷数据管理平台ADM包括生产数据备份、备份恢复校验、敏感数据处理、数据副本管理四大功能模块。kafka抽取

数据副本管理是上讯敏捷数据管理平台ADM功能模块之一,可单独作为企业级副本数据管理(CDM)产品。为应对当前复杂的IT环境,ADM提出集云、物理、虚拟为一体的,面向结构化数据库、非结构化数据、虚拟化和云平台的数据副本分发与交付管理解决方案。主要通过数据副本管理的核心专利技术——数据库虚拟化技术对源数据进行CDM原格式获取生成黄金副本、存储黄金副本作为基准数据、虚拟化为多个副本挂载恢复,达到快速交付副本数据、灵活管理副本数据版本、集中管理副本数据存储与流转的目标,是主要面向企业数据运维、软件开发测试部门解决自动化闭环取数供数、测试数据快速交付等典型应用场景的问题。kafka抽取