北京液冷电话

数据中心液冷市场创新极为活跃,关于浸没式、冷板式、喷淋式等多种液冷技术孰优孰劣的讨论此起彼伏。虽有“路线之争”,但无论选择哪种技术路线,成本仍是横在液冷技术普惠面前的拦路虎,据业界测算,目前液冷数据中心的初期建设成本比风冷要高出10%左右,需要1.5年才可实现总拥有成本与投资回报的平衡。此外,《白皮书》还指出,当前液冷技术存在生态不完善等问题。各家产品形态各异,产品规范化程度较低,难以标准化、规模化推广应用。哪家液冷的的性价比好?北京液冷电话

随着数据中心产业建设日趋成熟,传统方案无法实现PUE1.3以下的减碳目标已成为行业共识。在数据中心节能降碳政策的大力推广下,各地对数据中心PUE的管控也愈发严格。以东数西算工程为主的项目,要求北方地区实现PUE1.2,南方PUE1.25,如何实现?风冷?还是液冷?1.什么是液冷?随着全球信息化的高速发展,数字经济占GDP的比重持续攀升,据新研究表明,我国的这一比值已经达到38.6%。在云计算助力数字经济快速增长的背后,数据中心能耗急剧增长问题同样不容忽视。如何实现数据中心节能降耗,已经成为整个行业关注的焦点。传统服务器的冷却方式是通过空气进行换热,该技术方案很好的将IT设备与冷却设备进行了解耦,从而使得制冷系统形式能够实现多样化,但由于空气比热容较小,体积流量受服务器进风口大小限制,换热能力有限。北京液冷电话昆山性价比较好的液冷的公司联系电话。

首先是芯片厂商,后摩尔定律时代芯片算力与功耗同步大幅度提升,主流CPU、GPU厂商则选择加装冷却器、对接液冷系统,实现芯片的液冷散热。其中CPU方面,Intel2023Q1发布的第四代至强处理器多款子产品热设计功耗达350W,传统风冷解决方案散热压力极大,2023年1月Intel至强发布会上表明,第四代至强处理器将会配置液冷散热方案。GPU方面,2022年5月,英伟达宣布将在A100、H100系列产品中引入直接芯片(DirecttoChip)液冷散热技术,A10080GBPCIe将在尾部安置接口,以对接液冷系统。根据Equinix与NVIDIA的测试结果,液冷NVIDIAA100PCleGPU一方面可以在空间相同的条件下,实现双倍计算量;另一方面,采用液冷技术的数据中心工作负载可以与风冷设施持平,但能源消耗量将减少28%。同时,根据NVIDIA估计,采用液冷GPU的数据中心PUE可以达到1.15,远低于风冷的1.6。

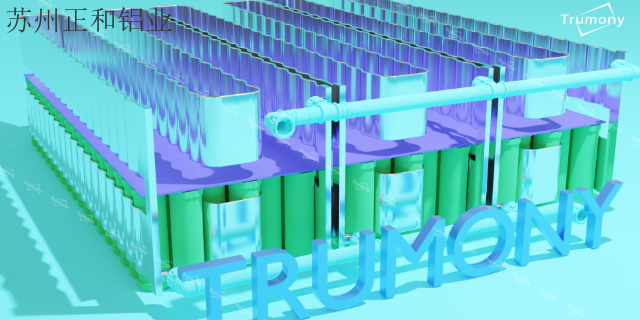

行业具有较高的进入壁垒,先进入者具备先发优势。(1)技术壁垒。液冷数据中心基础设施产品的研发和制造涉及冷却技术、制冷系统设计及仿真技术、温湿度解耦控制算法等多项技术领域,要求企业具备成熟、深入的技术积累。(2)专业人才壁垒。液冷数据中心基础设施领域属于新兴技术密集型产业,产品性能涉及材料化学、热力学、电子学、计算机科学等多种学科技术成果,并且因数据中心复杂多样,相应的制冷系统存在定制化特征,因此对研发技术人员的技术研发能力和行业经验要求较高。(3)客户认证壁垒。出于安全性、稳定性等考虑,企业客户在选择液冷数据中心基础设施供应商时通常需要进行严格的资质验证。另一方面,客户在与液冷数据中心基础设施供应商建立生产配套关系后,倾向于维持与现有技术供应商的合作,不会轻易更换主要供应商,因此先进入者具有先发优势。正和铝业为您提供液冷 ,有需要可以联系我司哦!

从产业规模上来看,数据中心的产业规模快速增长。根据中国信通院的数据显示,2021年,中国数据中心在用机架数量达520万架,较2020年增加超过100万架。《新型数据中心发展三年行动计划(2021-2023年)》指出,预计到2023年,中国数据中心在用数量将超过800万架。➢数据中心基础设施行业市场扩容,带动制冷需求增长。根据赛迪顾问数据,2019年我国数据中心基础设施的市场规模达161.9亿元,预计到2025年达到461.2亿元。根据工信部《新型数据中心发展三年行动计划(2021-2023年)》的文件,到2023年底,新建大型及以上数据中心PUE降低到1.3以下,我国绿色数据中心发展政策也指出,将计划降低数据中心能耗总体水平。液冷 ,就选正和铝业,用户的信赖之选,欢迎您的来电哦!安徽防水液冷多少钱

什么地方需要使用液冷。北京液冷电话

什么是风液共存?既然有风冷、液冷之分,那么,在同一个数据中心,是否可以同时使用这两种技术呢?有无矛盾?实践证明,完全可以做到“风液”共存。风液共存,有两种含义。同样的从室内侧和室外侧的散热方式上来理解,都有风液共存的场景和意义。从室内侧来理解,风液共存即指,在同一个数据中心,服务器既可以有采用空气冷却的子机房,也可以有用液冷的子机房。为什么要采用这种结构呢?这是由于目前液冷成本还较高,为了平衡初投资和PUE而采用的折中方式。水冷液冷制冷PUE可达1.09,而采用水冷风冷的数据中心PUE往往达到1.4以上,因此这两种方案混布,能够带来成本降低和PUE目标达成。如图4,在风液混布的数据中心,风冷和液冷分别处于不同的子机房,互相之间无干扰。北京液冷电话

上一篇: 海南水冷板液冷价钱

下一篇: 上海防水液冷厂家供应