DubaiH100GPU stock

硬件方面的TPU,Inferentia,LLMASIC和其他产品,以及软件方面的Mojo,Triton和其他产品,以及使用AMD硬件和软件的样子。我正在探索一切,尽管专注于***可用的东西。如果您是自由职业者,并希望帮助Llama2在不同的硬件上运行,请给我发电子邮件。到目前为止,我们已经在AMD,Gaudi上运行了TPU和Inferentia,并且来自AWSSilicon,R**n,Groq,Cerebras和其他公司的人员提供了帮助。确认#本文包含大量专有和以前未发布的信息。当您看到人们对GPU生产能力感到疑惑时,请向他们指出这篇文章的方向。感谢私有GPU云公司的少数高管和创始人,一些AI创始人,ML工程师,深度学习研究员,其他一些行业和一些非行业读者,他们提供了有用的评论。感谢哈米德的插图。A100\H100基本上越来越少,A800目前也在位H800让路,如果确实需要A100\A800\H100\H800GPU,建议就不用挑剔了,HGX和PCIE版对大部分使用者来说区别不是很大,有货就可以下手了。无论如何,选择正规品牌厂商合作,在目前供需失衡不正常的市场情况下,市面大部分商家是无法供应的,甚至提供不属实的信息。H100 GPU 适用于大数据分析任务。DubaiH100GPU stock

H100 GPU 在云计算平台中的应用也非常多。其高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。russiaH100GPU 的功耗设计为 400W。

以优化内存和缓存的使用和性能。H100HBM3和HBM2eDRAM子系统带宽性能H100L2cache采用分区耦合结构(partitionedcrossbarstructure)对与分区直接相连的GPC中的子模块的访存数据进行定位和高速缓存。L2cache驻留控制优化了容量利用率,允许程序员有选择地管理应该保留在缓存中或被驱逐的数据。内存子系统RAS特征RAS:Reliability,Av**lable,Serviceability(可靠性,可获得性)ECC存储弹性(MemoryResiliency)H100HBM3/2e存储子系统支持单纠错双检错(SECDED)纠错码(ECC)来保护数据。H100的HBM3/2e存储器支持"边带ECC",其中一个与主HBM存储器分开的小的存储区域用于ECC位内存行重映射H100HBM3/HBM2e子系统可以将产生错误ECC码的内存单元置为失效。并使用行重映射逻辑将其在启动时替换为保留的已知正确的行每个HBM3/HBM2e内存块中的若干内存行被预留为备用行,当需要替换被判定为坏的行时可以被。第二代安全MIGMIG技术允许将GPU划分为多达7个GPU事件(instance),以优化GPU利用率,并在不同客户端(例如VM、容器和进程等)之间提供一个被定义的QoS和隔离,在为客户端提供增强的安全性和保证GPU利用率之外,还确保一个客户端不受其他客户端的工作和调度的影响。

H100 GPU 是英伟达推出的一款高性能图形处理器,旨在满足当今数据密集型计算任务的需求。它采用新的架构,具备强大的计算能力和能效比,能够提升各种计算任务的效率和速度。无论是在人工智能、科学计算还是大数据分析领域,H100 GPU 都能提供良好的性能和可靠性。其并行处理能力和高带宽内存确保了复杂任务的顺利进行,是各类高性能计算应用的良好选择。H100 GPU 拥有先进的散热设计,确保其在长时间高负荷运行时依然能够保持稳定和高效。对于需要长时间运行的大规模计算任务来说,H100 GPU 的可靠性和稳定性尤为重要。它的设计不仅考虑了性能,还兼顾了散热和能效,使其在保持高性能的同时,依然能够节省能源成本。无论是企业级应用还是科学研究,H100 GPU 都能够为用户提供持续的高性能支持。H100 GPU 支持 NVIDIA NVLink 技术。

他们与英伟达合作托管了一个基于NVIDIA的集群。Nvidia也是Azure的客户。哪个大云拥有好的网络?#Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的网络,它是3200Gbps,但它是以太网而不是InfiniBand,对于高参数计数LLM训练等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的网络就没有那么好了。企业使用哪些大云?#在一个大约15家企业的私有数据点中,所有15家都是AWS,GCP或Azure,零甲骨文。大多数企业将坚持使用现有的云。绝望的初创公司会去哪里,哪里就有供应。DGXCloud怎么样,英伟达正在与谁合作?#“NVIDIA正在与的云服务提供商合作托管DGX云基础设施,从Oracle云基础设施(OCI)开始”-您处理Nvidia的销售,但您通过现有的云提供商租用它(首先使用Oracle启动,然后是Azure,然后是GoogleCloud,而不是使用AWS启动)3233Jensen在上一次财报电话会议上表示:“理想的组合是10%的NvidiaDGX云和90%的CSP云。大云什么时候推出他们的H100预览?#CoreWeave是个。34英伟达给了他们较早的分配,大概是为了帮助加强大型云之间的竞争(因为英伟达是投资者)。Azure于13月100日宣布H<>可供预览。35甲骨文于21月100日宣布H<>数量有限。H100 GPU 价格直降,抢购从速。IranH100GPU stock

H100 GPU 支持 PCIe 4.0 接口。DubaiH100GPU stock

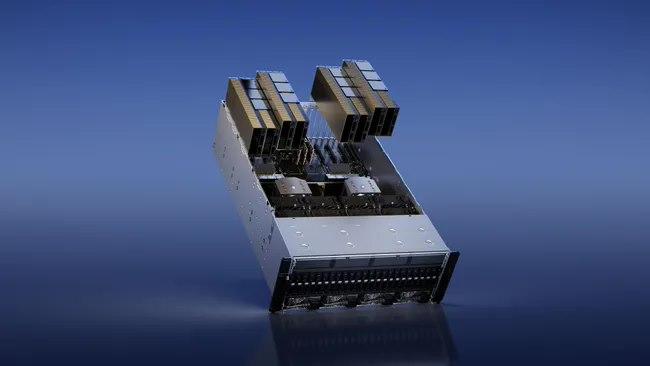

H100 GPU 采用了 NVIDIA 的架构技术,其架构采用 Ampere 架构,使其在性能和能效方面都达到了一个新的高度。H100 GPU 具有 8192 个 CUDA ,能够提供极高的并行处理能力,对于需要大量计算资源的任务,如深度学习训练和科学计算,H100 GPU 能够提升效率。其基础时钟频率为 1410 MHz,增强时钟频率可达 1665 MHz,确保在高负载下依然能够提供稳定的性能输出,其 Tensor Core 性能可达 312 TFLOPS,特别适合深度学习和神经网络训练等需要大量矩阵运算的任务,极大地提升了计算效率。DubaiH100GPU stock

上一篇: N9K-C9504-FAN 优惠价

下一篇: N9K-C9500-P-CV 供应商