硬盘H100GPU促销价

视频编辑需要处理大量的图像和视频数据,H100 GPU 的强大计算能力为此类任务提供了极大的便利。其高带宽内存和并行处理能力能够快速渲染和编辑高分辨率视频,提升工作效率。无论是实时预览、明显处理还是多层次剪辑,H100 GPU 都能流畅应对,减少卡顿和渲染时间。其高能效设计和稳定性确保了视频编辑过程的顺利进行,使其成为视频编辑领域的理想选择。虚拟现实(VR)开发对图形处理和计算能力有极高要求,H100 GPU 的性能使其成为 VR 开发的重要工具。其高并行计算能力和大带宽内存可以高效处理复杂的 VR 场景和互动效果,提供流畅的用户体验。H100 GPU 的高分辨率渲染能力能够实现更逼真的视觉效果,提升 VR 应用的沉浸感。此外,H100 GPU 的稳定性和高能效设计也为长时间开发和测试提供了可靠保障,助力开发者创造出更具吸引力的 VR 应用。H100 GPU 在科学计算领域表现出色。硬盘H100GPU促销价

H100 GPU 在边缘计算中的应用也非常。其高性能计算能力和低功耗设计使其非常适合用于边缘计算。H100 GPU 的强大并行处理能力可以高效处理实时数据,提升应用的响应速度和可靠性。无论是在智能制造、智慧城市还是物联网应用中,H100 GPU 都能提升数据处理效率,满足边缘计算的需求。其紧凑设计和高能效比为边缘计算设备提供了理想的硬件支持,是边缘计算领域的重要组成部分。

ITMALL.sale 是一家专业的 H100 GPU 代理商,以其的服务和高质量的产品赢得了广大客户的信赖。作为 NVIDIA 官方授权的代理商,ITMALL.sale 提供全系列的 H100 GPU 产品,确保客户能够获得、的图形处理器。无论是企业级应用还是个人用户,ITMALL.sale 都能够提供个性化的解决方案,满足不同客户的需求。ITMALL.sale 不仅提供产品销售,还为客户提供的技术支持和售后服务,确保客户在使用 H100 GPU 过程中无后顾之忧。 硬盘H100GPU促销价H100 GPU 限时降价,数量有限。

大多数GPU用于什么用途?#对于使用私有云(CoreWeave、Lambda)的公司,或拥有数百或数千台H100的公司,几乎都是LLM和一些扩散模型工作。其中一些是对现有模型的微调,但大多数是您可能还不知道的从头开始构建新模型的新创业公司。他们正在签订为期3年、价值1000万至5000万美元的合同,使用几百到几千台GPU。对于使用带有少量GPU的按需H100的公司来说,其LLM相关使用率可能仍>50%。私有云现在开始受到企业的青睐,这些企业通常会选择默认的大型云提供商,但现在大家都退出了。大型人工智能实验室在推理还是训练方面受到更多限制?#取决于他们有多少产品吸引力!SamAltman表示,如果必须选择,OpenAI宁愿拥有更多的推理能力,但OpenAI在这两方面仍然受到限制。

第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加(MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍;稀疏性特征利用了深度学习网络中的细粒度结构化稀疏性,使标准张量性能翻倍。新的DPX指令加速了动态规划算法达到7倍。IEEEFP64和FP32的芯片到芯片处理速率提高了3倍(因为单个SM逐时钟(clock-for-clock)性能提高了2倍;额外的SM数量;更快的时钟)新的线程块集群特性(ThreadBlockClusterfeature)允许在更大的粒度上对局部性进行编程控制(相比于单个SM上的单线程块)。这扩展了CUDA编程模型,在编程层次结构中增加了另一个层次,包括线程(Thread)、线程块(ThreadBlocks)、线程块集群(ThreadBlockCluster)和网格(Grids)。集群允许多个线程块在多个SM上并发运行,以同步和协作的获取数据和交换数据。新的异步执行特征包括一个新的张量存储加速(TensorMemoryAccelerator,TMA)单元,它可以在全局内存和共享内存之间非常有效的传输大块数据。TMA还支持集群中线程块之间的异步拷贝。还有一种新的异步事务屏障。H100 GPU 配备 80GB 的 HBM2e 高带宽内存。

它可能每年产生$500mm++的经常性收入。ChatGPT运行在GPT-4和API上。GPT-4和API需要GPU才能运行。很多。OpenAI希望为ChatGPT及其API发布更多功能,但他们不能,因为他们无法访问足够的GPU。他们通过Microsoft/Azure购买了很多NvidiaGPU。具体来说,他们想要的GPU是NvidiaH100GPU。为了制造H100SXMGPU,Nvidia使用台积电进行制造,并使用台积电的CoWoS封装技术,并使用主要来自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他们是产品市场契合度强的公司)。其他公司也希望训练大型AI模型。其中一些用例是有意义的,但有些用例更多的是驱动的,不太可能使产品与市场契合。这推高了需求。此外,一些公司担心将来无法访问GPU,因此即使他们还不需要它们,他们现在也会下订单。因此,“对供应短缺的预期会造成更多的供应短缺”正在发生。GPU需求的另一个主要贡献者来自想要创建新的LLM的公司。以下是关于想要构建新LLM的公司对GPU需求的故事:公司高管或创始人知道人工智能领域有很大的机会。也许他们是一家想要在自己的数据上训练LLM并在外部使用它或出售访问权限的企业,或者他们是一家想要构建LLM并出售访问权限的初创公司。他们知道他们需要GPU来训练大型模型。H100 GPU 优惠销售,机会难得。硬盘H100GPU促销价

H100 GPU 促销降价,快来选购。硬盘H100GPU促销价

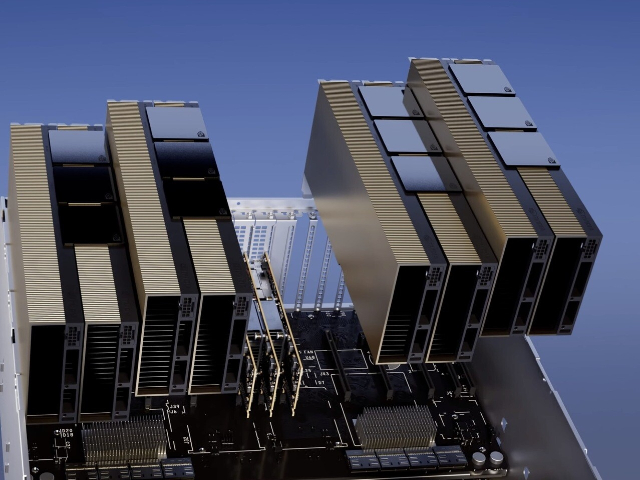

利用 NVIDIA H100 Tensor GPU,提供所有工作负载前所未有的效能、可扩展性和安全性。 使用 NVIDIA® NVLink® Switch 系统,比较高可连接 256 个 H100 来加速百万兆级工作负载,此外还有的 Transformer Engine,可解决一兆参数语言模型。 H100 所结合的技术创新,可加速大型语言模型速度,比前一代快上 30 倍,提供业界的对话式人工智能。英伟达 DGX SuperPOD架构采用英伟达的NVLink和NVSwitch系统,多可连接32个DGX节点,共256个H100 GPU。这是一个真正的人工智能基础设施平台;英伟达的DGX SuperPOD数据中心设计[4]让我们对真正的企业人工智能基础设施的巨大功率和冷却需求有了一些了解。硬盘H100GPU促销价

上一篇: QatarH100GPU现货

下一篇: 上海ISR 4431路由器功能